GPU CLOUD: SERVER GPU MẠNH MẼ CHO XỬ LÝ AI/ML

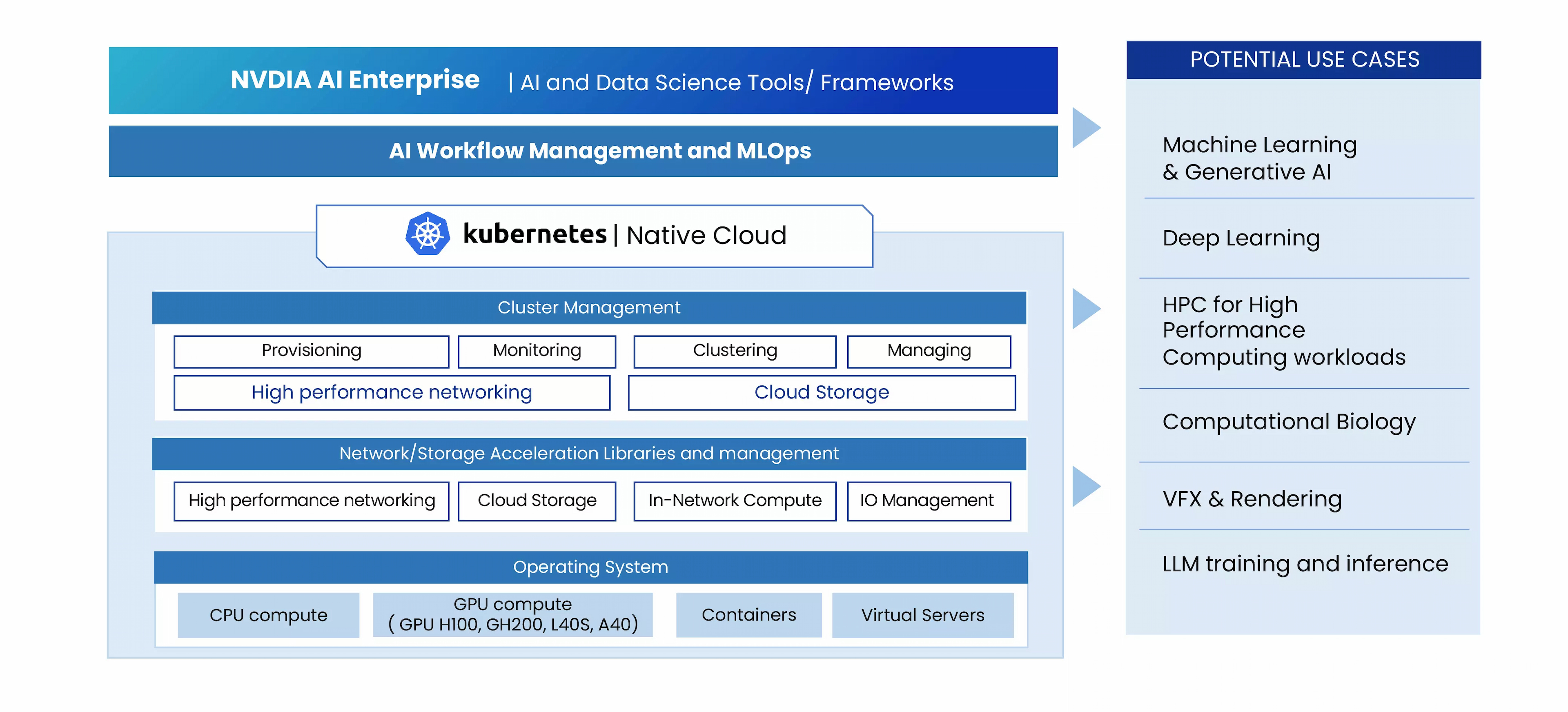

High Performance GPU Cloud là một nền tảng mạnh mẽ và hiện đại, tập trung vào việc mang lại hiệu suất GPU vượt trội. Giải pháp đám mây này được thiết kế riêng cho nhiều ứng dụng cao cấp, từ AI, Machine Learning, Deep Learning, mô hình Large Language (LLM) đến các tác vụ yêu cầu tài nguyên điện toán cao.

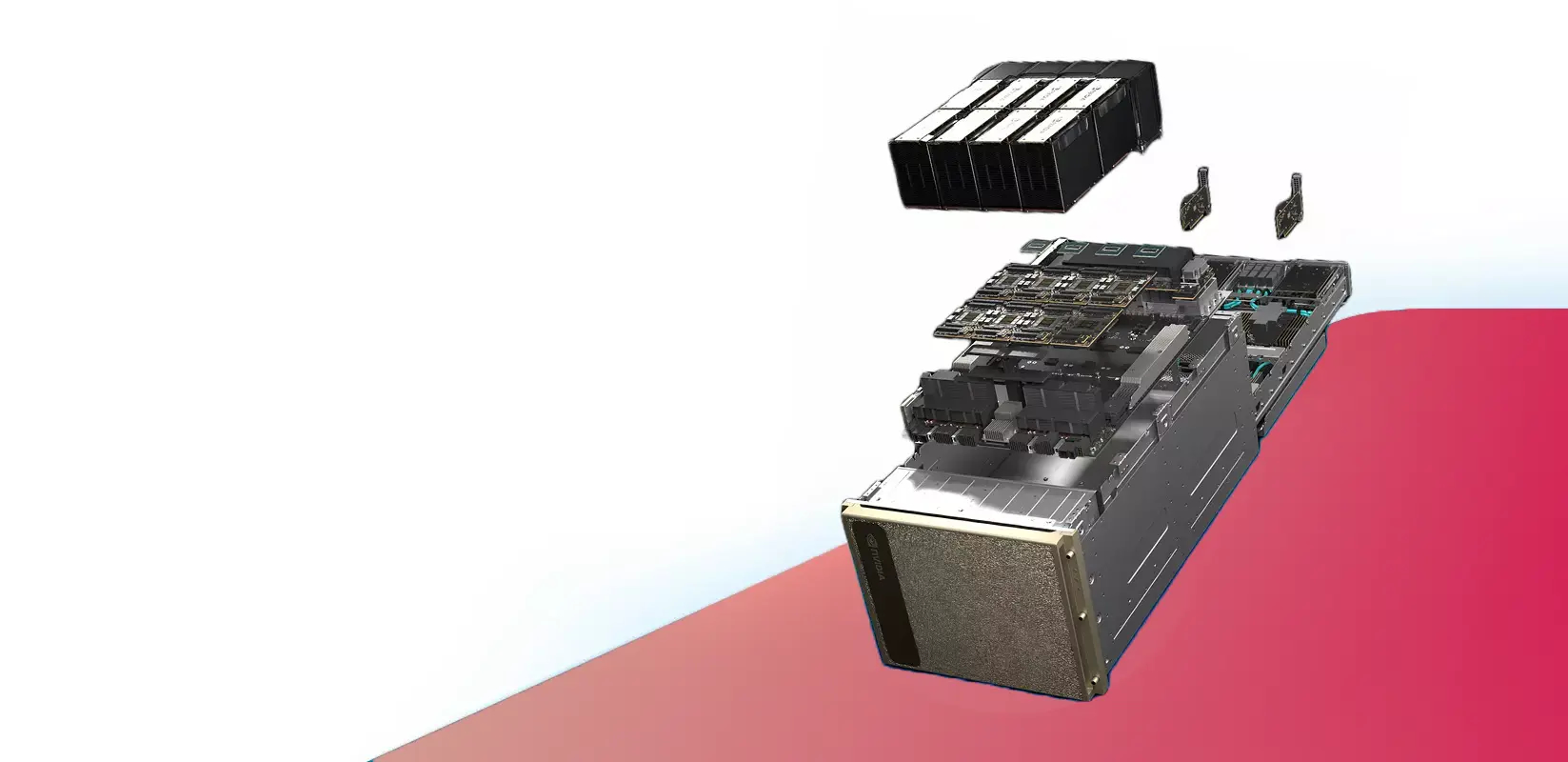

Các server GPU chuyên dụng của chúng tôi luôn sẵn sàng để đáp ứng nhu cầu xử lý khối lượng dữ liệu phức tạp cao như hiện nay.

FEATURES

GPU Instances

EDễ dàng chạy các container instance trên GPU từ kho lưu trữ công cộng hoặc riêng tư chỉ trong vài giây.

TẠI SAO CHỌN GPU CLOUD?

Lý tưởng cho các tác vụ AI/ML/Deep Learning/LLM

GPU Cloud là lựa chọn hoàn hảo cho các tác vụ AI/ML/Deep Learning/LLM, với khả năng truy cập linh hoạt vào các tài nguyên GPU mạnh mẽ để đào tạo mô hình và xử lý dữ liệu hiệu quả.

Hiệu suất đáng tin cậy

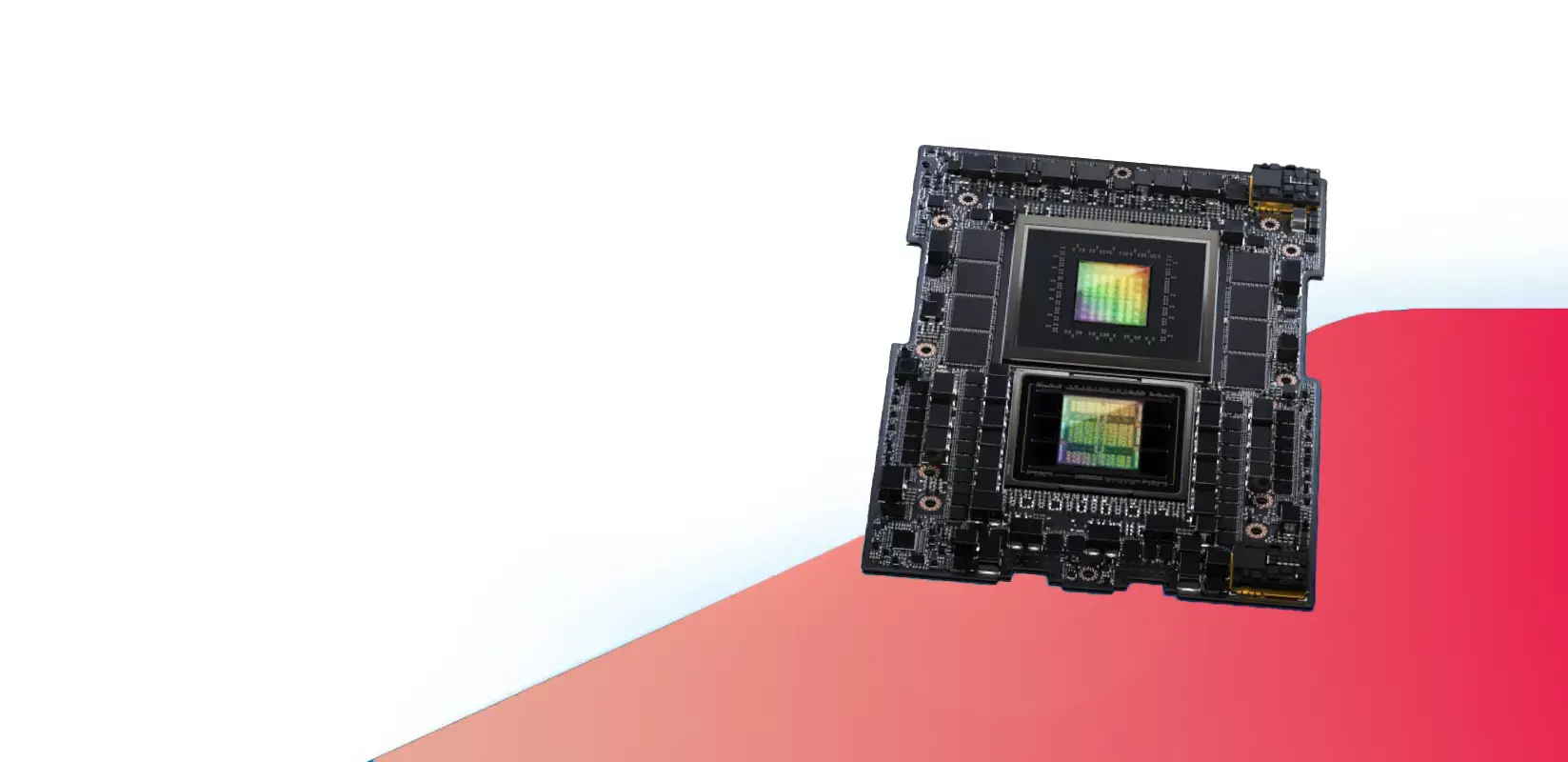

Các dòng chip GPU NVIDIA mạnh mẽ (H100, GH200, L40S, A40) đảm bảo hiệu suất vượt trội cho nhiều tác vụ cần tài nguyên GPU lớn, từ AI và ML đến Deep Learning và VFX Render.

Mức độ bảo mật cao

GPU được đặt trong Trung tâm dữ liệu Uptime Tier III. VietStack luôn ưu tiên bảo mật cho dữ liệu của bạn và cung cấp các tùy chọn tuân thủ để đáp ứng các tiêu chuẩn ngành.

Khả năng mở rộng và sự linh hoạt

Bất kể sự gia tăng nhu cầu đột biến cho đào tạo mô hình hay tài nguyên điện toán cho các tác vụ phức tạp, GPU Cloud có thể dễ dàng tăng hoặc giảm quy mô tùy theo dự án của bạn.

Hiệu quả về chi phí

Với Pay-as-you-go, dịch vụ GPU Cloud giúp tối ưu hóa ngân sách triển khai mô hình AI/ML trong doanh nghiệp bằng cách chỉ trả phí cho phần tài nguyên sử dụng.

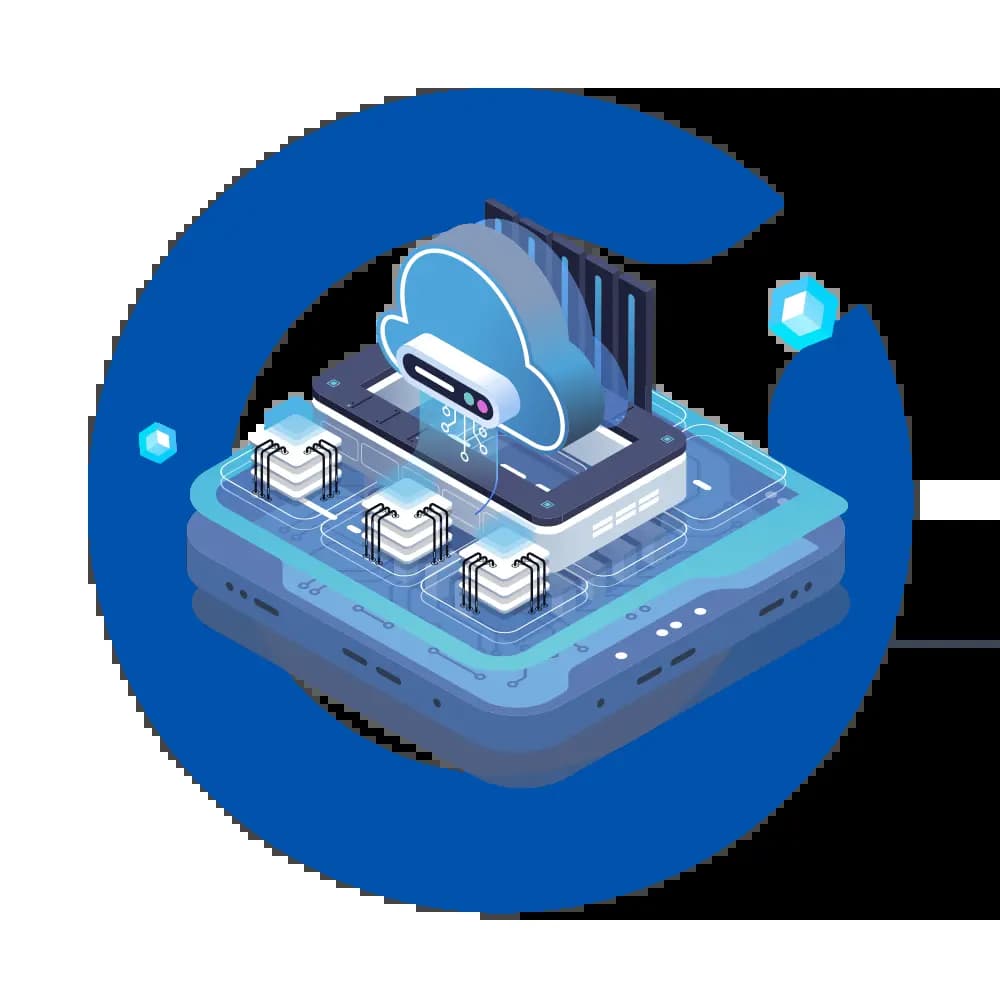

SƠ ĐỒ HOẠT ĐỘNG